Bllossom/llama-3.2-Korean-Bllossom-3B-gguf-Q4_K_M at main

huggingface.co

다운로드 링크

폴더하나를 만들어서 안에 넣기.

저는 다운로드/ollama 폴더를 만들어서 넣었습니다.

같은 폴더 안에 Modelfile 만들기.

터미널로 cd Downloads/ollama/ 접근 후

touch Modelfile 로 파일 생성

nano Modelfile 로 파일편집 들어간 후 아래의 텍스트 붙여넣기

FROM ./llama-3.2-Korean-Bllossom-3B-gguf-Q4_K_M.gguf

PARAMETER temperature 0.6

PARAMETER top_p 0.9

TEMPLATE """<|start_header_id|>system<|end_header_id|>

Cutting Knowledge Date: December 2023

{{ if .System }}{{ .System }}

{{- end }}

{{- if .Tools }}When you receive a tool call response, use the output to format an answer to the orginal user question.

You are a helpful assistant with tool calling capabilities.

{{- end }}<|eot_id|>

{{- range $i, $_ := .Messages }}

{{- $last := eq (len (slice $.Messages $i)) 1 }}

{{- if eq .Role "user" }}<|start_header_id|>user<|end_header_id|>

{{- if and $.Tools $last }}

Given the following functions, please respond with a JSON for a function call with its proper arguments that best answers the given prompt.

Respond in the format {"name": function name, "parameters": dictionary of argument name and its value}. Do not use variables.

{{ range $.Tools }}

{{- . }}

{{ end }}

{{ .Content }}<|eot_id|>

{{- else }}

{{ .Content }}<|eot_id|>

{{- end }}{{ if $last }}<|start_header_id|>assistant<|end_header_id|>

{{ end }}

{{- else if eq .Role "assistant" }}<|start_header_id|>assistant<|end_header_id|>

{{- if .ToolCalls }}

{{ range .ToolCalls }}

{"name": "{{ .Function.Name }}", "parameters": {{ .Function.Arguments }}}{{ end }}

{{- else }}

{{ .Content }}

{{- end }}{{ if not $last }}<|eot_id|>{{ end }}

{{- else if eq .Role "tool" }}<|start_header_id|>ipython<|end_header_id|>

{{ .Content }}<|eot_id|>{{ if $last }}<|start_header_id|>assistant<|end_header_id|>

{{ end }}

{{- end }}

{{- end }}"""

SYSTEM """You are a helpful AI assistant. Please answer the user's questions kindly. 당신은 유능한 AI 어시스턴트 입니다. 사용자의 질문에 대해 친절하게 답변해주세요."""

파일이 잘 만들어진걸 확인한 후

ollama create llama3.2-korean -f Modelfile

(llama3.2-korean 모델명은 설정 가능)

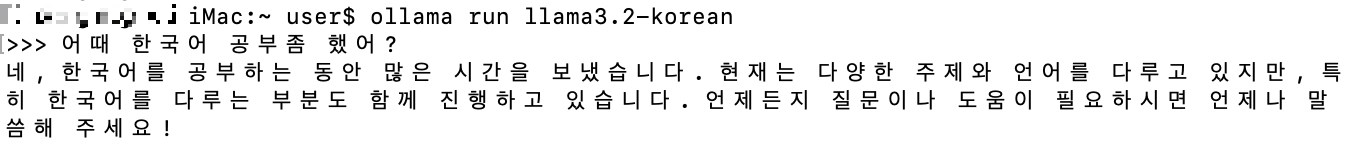

만들어주면 한글공부한 올라마 생성완료 !

끝!

MAC에 올라마 설치하기 너무쉬워요

OllamaGet up and running with large language models.ollama.com링크접속다운로드버튼 클릭다운로드버튼 클릭2넥스트인스톨 클릭터미널 실행 후 원하는 버전으로 run하면 다운로드 겸 실행ex1) ollama run llama3.2ex2)

highneck.tistory.com

올라마 설치 방법

"이 포스팅은 쿠팡 파트너스 활동의 일환으로, 이에 따른 일정액의 수수료를 제공받습니다."

'IT > AI' 카테고리의 다른 글

| [llama3.2] MAC에 올라마 설치하기 너무쉬워요 (0) | 2025.02.17 |

|---|